Nginx 是一个高性能的 HTTP 和反向代理服务器,特点是占用内存少,并发能力强,事实上 Nginx 的并发能力确实在同类型的网页服务器中表现较好。

Nginx 专为性能优化而开发,性能是其最重要的要求,十分注重效率,有报告 Nginx 能支持高达 50000 个并发连接数。

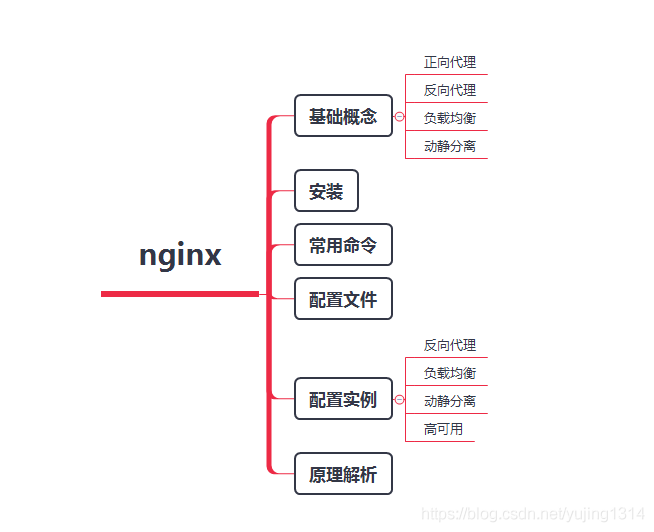

一、Nginx相关知识

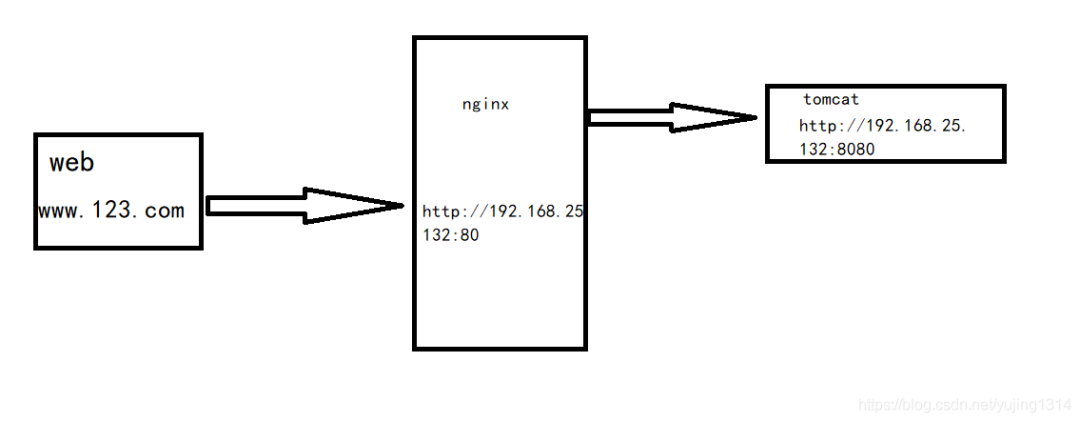

1、网结构图

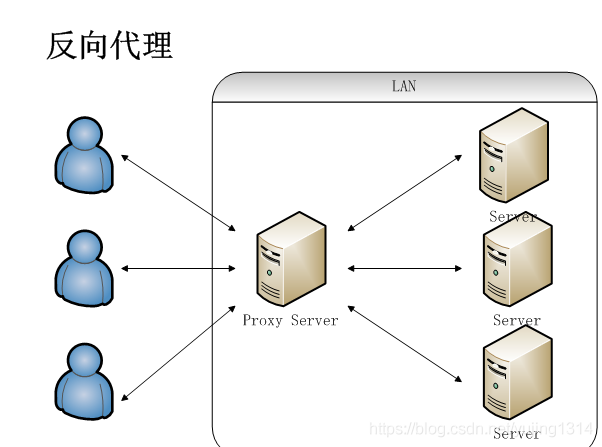

2、反向代理

-

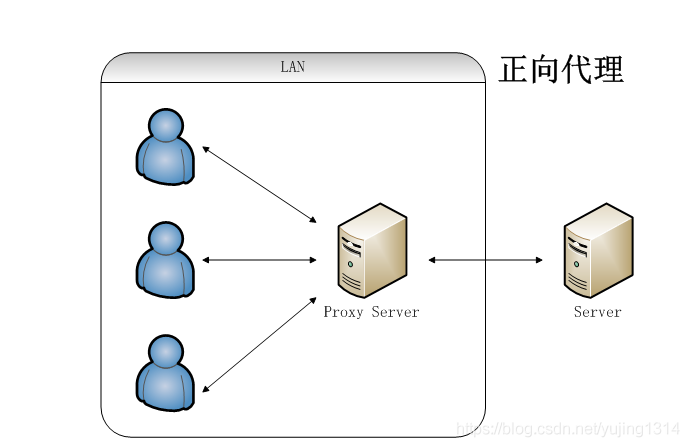

正向代理: 局域网中的电脑用户想要直接访问网络是不可行的,只能通过代理服务器来访问,这种代理服务就被称为正向代理。

-

反向代理: 客户端无法感知代理,因为客户端访问网络不需要配置,只要把请求发送到反向代理服务器,由反向代理服务器去选择目标服务器获取数据,然后再返回到客户端。

此时反向代理服务器和目标服务器对外就是一个服务器,暴露的是代理服务器地址,隐藏了真实服务器 IP 地址。

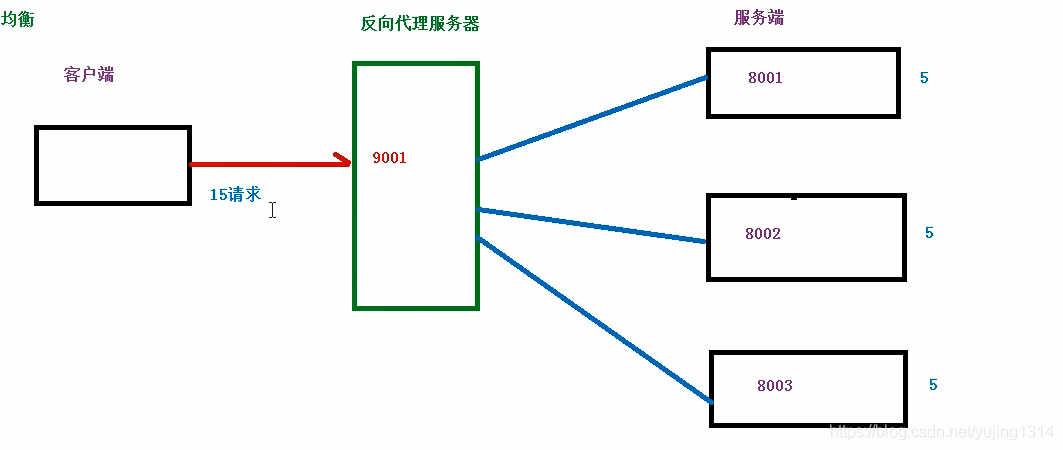

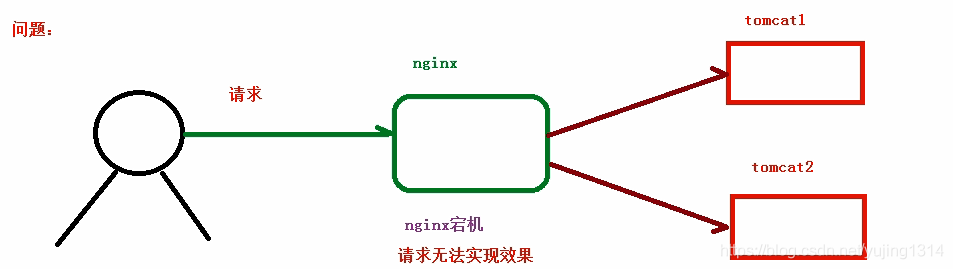

3、负载均衡

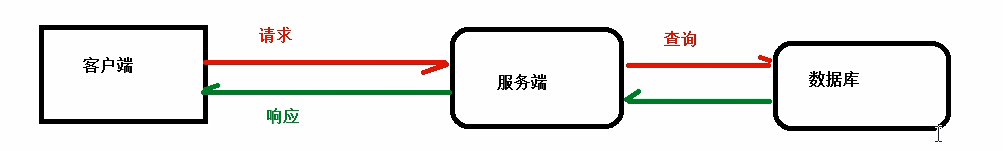

客户端发送多个请求到服务器,服务器处理请求,有一些可能要与数据库进行交互,服务器处理完毕之后,再将结果返回给客户端。

-

普通请求和响应过程如下图:

但是随着信息数量增长,访问量和数据量飞速增长,普通架构无法满足现在的需求。我们首先想到的是升级服务器配置,可以由于摩尔定律的日益失效,单纯从硬件提升性能已经逐渐不可取了,怎么解决这种需求呢?

我们可以增加服务器的数量,构建集群,将请求分发到各个服务器上,将原来请求集中到单个服务器的情况改为请求分发到多个服务器,也就是我们说的负载均衡。

-

图解负载均衡:

假设有 15 个请求发送到代理服务器,那么由代理服务器根据服务器数量,平均分配,每个服务器处理 5 个请求,这个过程就叫做负载均衡。

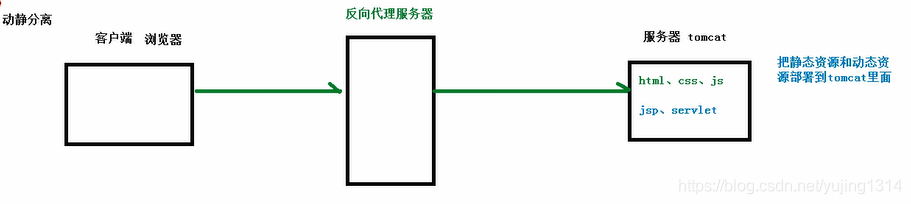

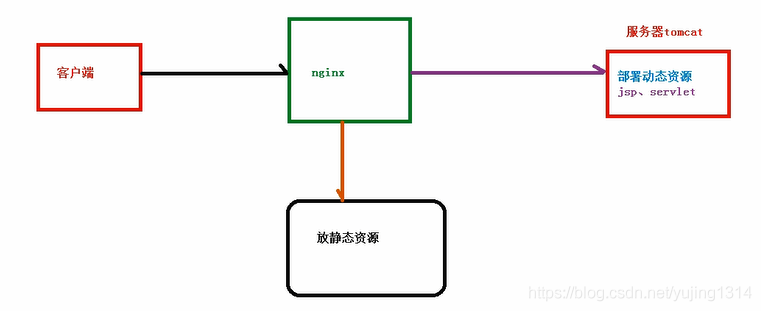

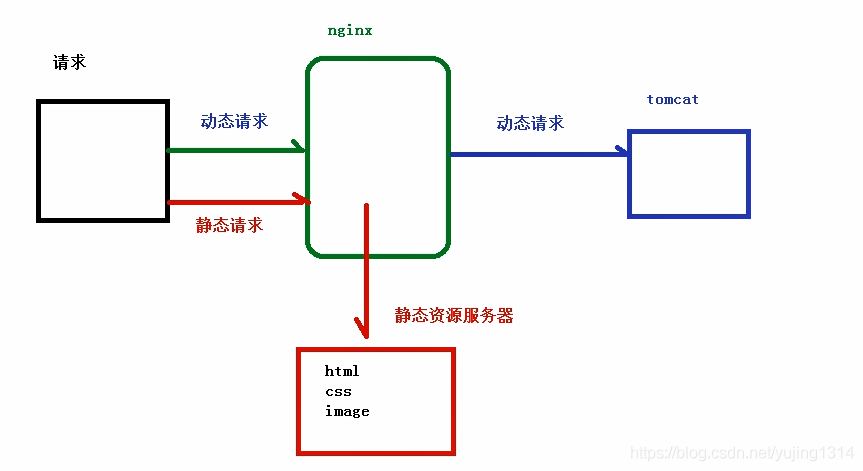

4、动静分离

为了加快网站的解析速度,可以把动态页面和静态页面交给不同的服务器来解析,加快解析的速度,降低由单个服务器的压力。

- 动静分离之前的状态:

- 动静分离之后:

二、Nginx安装

基于 Centos7.6

1、yum安装(推荐)

yum install nginx

# 默认配置文件目录

/etc/nginx/

2、编译安装

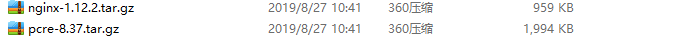

- 下载nginx、pcre压缩包,并上传到服务器上

-

安装pcre依赖

cd /root # 解压 tar -zxvf pcre-8.37.tar.gz cd pcre-8.37 # 进入pcre目录 # 配置 ./configure # 编译安装 make && make install # 查看是否安装成功 pcre-config --version -

安装其它依赖

yum -y install make zlib zlib-devel gcc-c++ libtool openssl openssl-devel -

安装nginx

cd /root # 解压 tar -zxvf nginx-1.12.2.tar.gz # 进入目录 cd nginx-1.12.2 # 配置 ./configure # 编译安装 make && make install # 进入nginx可执行目录 cd /usr/local/nginx/sbin # 启动ngnix ./nginx # 查看是否启动 ps -ef|grep nginx

3、常用命令

- 查看版本

./nginx -v - 启动

./nginx - 关闭(有两种方式,推荐使用 ./nginx -s quit):

./nginx -s stop ./nginx -s quit - 重新加载 Nginx 配置

./nginx -s reload

4、Nginx配置文件介绍

-

全局块

从配置文件开始到 events 块之间,主要是设置一些影响 Nginx 服务器整体运行的配置指令。

并发处理服务的配置,值越大,可以支持的并发处理量越多,但是会受到硬件、软件等设备的制约。# user nobody; worker processes 1; # 并发数 -

events 块

影响 Nginx 服务器与用户的网络连接,常用的设置包括是否开启对多 workprocess 下的网络连接进行序列化,是否允许同时接收多个网络连接等等。events { worker connections 1024; # 支持的最大连接数: } -

HTTP 块

诸如反向代理和负载均衡都在此配置。location 指令说明,该语法用来匹配 url,语法如上:

- =:用于不含正则表达式的 url 前,要求字符串与 url 严格匹配,匹配成功就停止向下搜索并处理请求。

- ~:用于表示 url 包含正则表达式,并且区分大小写。

- ~*:用于表示 url 包含正则表达式,并且不区分大小写。

- ^~:用于不含正则表达式的 url 前,要求 Nginx 服务器找到表示 url 和字符串匹配度最高的 location 后,立即使用此 location 处理请求,而不再匹配。

- 如果有 url 包含正则表达式,不需要有 ~ 开头标识。

location[ = | ~ | ~* | ^~] url{ }

三、实战

所有操作都基于 nginx.conf 或者自定义的xxxx.conf 配置文件编写

1、反向代理实战

具体流程如下图

- 示例A:域名指向单台服务

server {

listen 80;

server_name www.123.com;

add_header X-Frame-Options SAMEORIGIN;

root html;

index index.html index.htm;

location /nginx_status {

deny all;

}

location / {

proxy_pass http://192.168.25.123:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

- 示例B:域名指向多台服务

server {

listen 80;

server_name www.123.com;

add_header X-Frame-Options SAMEORIGIN;

root html;

index index.html index.htm;

location /nginx_status {

deny all;

}

# 访问 http://www.123.com/edu/ 路径结构的转到192.168.25.132:8080服务

location /edu/ {

proxy_pass http://192.168.25.123:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

# 访问 http://www.123.com/vod/ 路径结构的转到192.168.25.132:8081服务

location /vod/ {

proxy_pass http://192.168.25.123:8081;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

# 其它不允许访问

location / {

deny all;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

- 修改配置需要重载配置才能生效

#方式一: 需要到执行文件目录

./nginx -s reload

# 方式二:直接执行(前提nginx已经是系统服务)

# nginx -s reload

2、负载均衡实战

场景:本地有两台一样业务的服务,需要做负载

- weight:代表权,权越高优先级越高

- fair:按后端服务器的响应时间来分配请求,相应时间短的优先分配

- ip_hash:每个请求按照访问 ip 的 hash 结果分配,这样每一个访客固定的访问一个后端服务器,可以解决 Session 的问题

# 方案一:weight 代表权,权越高优先级越高

upstream myserver {

server 192.168.25.123:8081 weight=1; #服务一

server 192.168.25.123:8080 weight=1; #服务二

}

# 方案二: fair 按后端服务器的响应时间来分配请求,相应时间短的优先分配

# upstream myserver {

# server 192.168.25.123:8081; #服务一

# server 192.168.25.123:8080; #服务二

# fair;

# }

# 方案三: ip_hash 每个请求按照访问 ip 的 hash 结果分配,这样每一个访客固定的访问一个后端服务器,可以解决 Session 的问题

# upstream myserver {

# ip_hash;

# server 192.168.25.123:8081; #服务一

# server 192.168.25.123:8080; #服务二

# }

server {

listen 80;

server_name www.123.com;

add_header X-Frame-Options SAMEORIGIN;

root html;

index index.html index.htm;

location /nginx_status {

deny all;

}

location / {

proxy_pass http://myserver;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

3、动静分离实战

什么是动静分离?把动态请求和静态请求分开,不是讲动态页面和静态页面物理分离,可以理解为 Nginx 处理静态页面,Tomcat 处理动态页面。

具体流程如下图:

server {

listen 80;

server_name www.123.com;

add_header X-Frame-Options SAMEORIGIN;

root html;

index index.html index.htm;

location /nginx_status {

deny all;

}

# 后缀为如下的走静态资源目录

location ~* .(gif|jpg|jpeg|css|ico|html|js|png|map|scss|txt|woff|ttf)$ {

index index.html;

root /usr/share/nginx/html/web;

}

location / {

proxy_pass http://192.168.25.123:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

4、各类常用正则示例及SSL证书

server {

listen 80;

server_name www.123.com;

add_header X-Frame-Options SAMEORIGIN;

location /nginx_status {

deny all;

}

location / {

return 301 https://$server_name$request_uri;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

server {

listen 443 ssl;

server_name www.123.com;

ssl_certificate /etc/ssl/certs/apps.rhinox.cn.pem;

ssl_certificate_key /etc/ssl/certs/apps.rhinox.cn.key;

ssl_session_timeout 5m;

ssl_ciphers ECDHE-RSA-AES128-GCM-SHA256:ECDHE:ECDH:AES:HIGH:!NULL:!aNULL:!MD5:!ADH:!RC4;

ssl_protocols TLSv1 TLSv1.1 TLSv1.2;

ssl_prefer_server_ciphers on;

# 引入禁止一些ip进行访问,格式为 deny 128.14.141.34; 一行一条

# include /etc/nginx/conf.d/deny_ip.conf;

location /nginx_status {

deny all;

}

# 访问 http://www.123.com 自动访问 http://www.123.com/index.html 且显示地址不变

location =/ {

proxy_pass https://www.123.com/index.html;

}

# 访问 http://www.123.com/a.do 进入

location /a.do {

deny all; # 指的是禁止

}

# 访问 http://www.123.com/admin/****** 时走服务端8081

location ~* /admin/ {

proxy_pass http://192.168.25.123:8081;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

# 后缀为如下的走静态资源目录

location ~* .(gif|jpg|jpeg|css|ico|html|js|png|map|scss|txt|woff|ttf)$ {

index index.html;

root /usr/share/nginx/html/web;

}

location / {

proxy_pass http://192.168.25.123:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 1;

proxy_read_timeout 30;

proxy_send_timeout 30;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

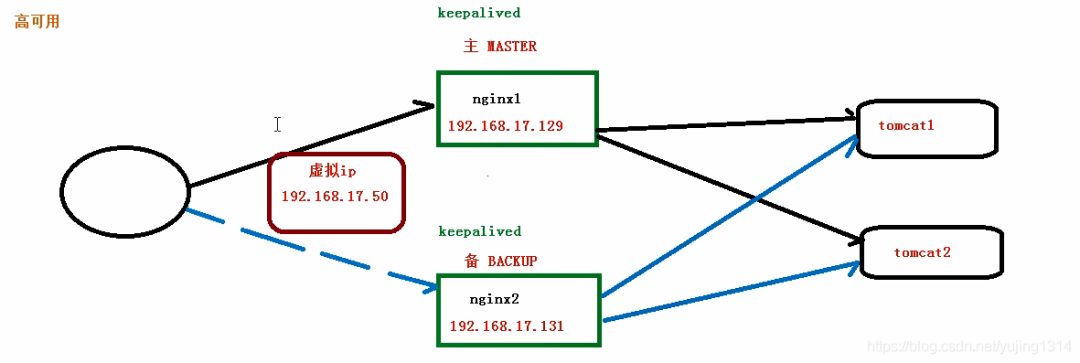

四、Nginx高可用

为什么要使用nginx的高可用: 因为nginx作为反向代理服务器时,有可能出现宕机的情况,而由于其反向代理的特性,就会导致其他服务器(tomcat等)无法被访问,这样项目就停止工作了。但是使用了高可用后,就可以避免这种现象出现。

什么是高可用: nginx的高可用简单来说就是配置了两台(或更多)的nginx服务器,当主服务器宕机时,就会自动切换到备用服务器,从而保证项目的持续运行。

高可用的原理: nginx的实现需要借助其他工具(keepalived)来实现。在keepalived中配置一个虚拟IP(VIP),同时keepalived会定时检查主服务器的工作状态(通过脚本实现)。在主服务器正常工作时,VIP就会映射到主服务器的IP,此时,虚拟ip对应的物理地址和主服务器IP对应的物理地址是相同的,所以访问虚拟IP即访问主服务器。当主服务器失效时,脚本就会监测到,从而根据预先的配置,找到优先级最高的备用服务器,并将虚拟IP映射到该备用服务器的ip,此时,这两个ip对应的物理地址时相同的。再主服务器回复正常时,又会被检测到,又会自动切换到主服务器。这样就实现了nginx的高可用。

具体流程如下图:

1、前期准备

- 两台 Nginx 服务器:192.168.17.129、192.168.17.131

- 安装 Keepalived:分别安装到两台服务器上

- 虚拟 ip:192.168.17.50

2、安装Keepalived

# yum 安装

yum install keepalived -y

# 查看是否安装

rpm -q -a keepalived

3、配置

cd /etc/keepalived

# 编辑

vi keepalived.conf

对应主机 ip 需要修改的是:

- smtp_server 192.168.17.129(主)smtp_server 192.168.17.131(备)

- state MASTER(主) state BACKUP(备)

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.17.129

smtp_connect_timeout 30

router_id LVS_DEVEL # 访问的主机地址

}

vrrp_script chk_nginx {

script "/usr/local/src/nginx_check.sh" # 检测文件的地址

interval 2 # 检测脚本执行的间隔

weight 2 # 权重

}

vrrp_instance VI_1 {

state BACKUP # 主机MASTER、备机BACKUP

interface ens33 # 网卡

virtual_router_id 51 # 同一组需一致

priority 90 # 访问优先级,主机值较大,备机较小

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.25.50 # 虚拟ip

}

}

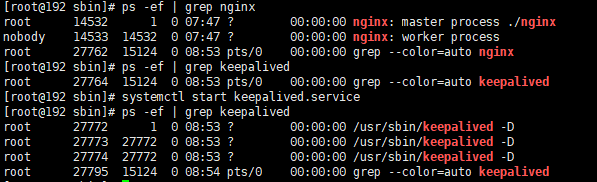

4、启动

systemctl start keepalived.service

访问虚拟 ip 成功:

关闭主机 147 的 Nginx 和 Keepalived,发现仍然可以访问。

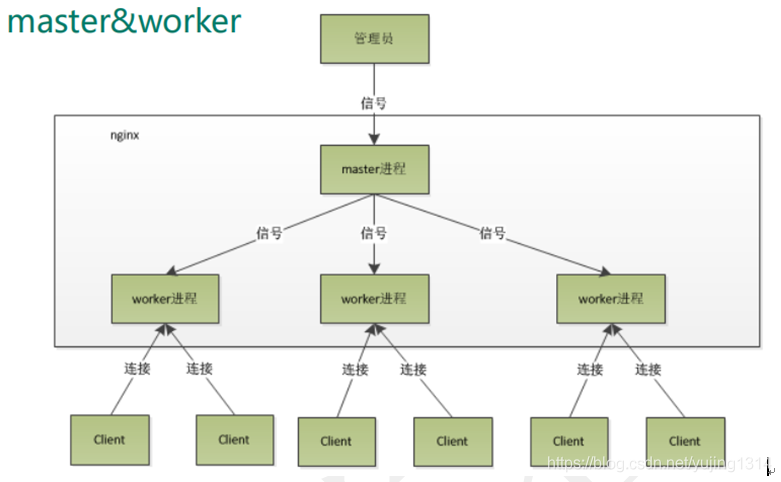

5、原理解析

就是启动了一个 master,一个 worker,master 是管理员,worker是具体工作的进程。

worker 数应该和 CPU 数相等;一个 master 多个 worker 可以使用热部署,同时 worker 是独立的,一个挂了不会影响其他的。

评论区